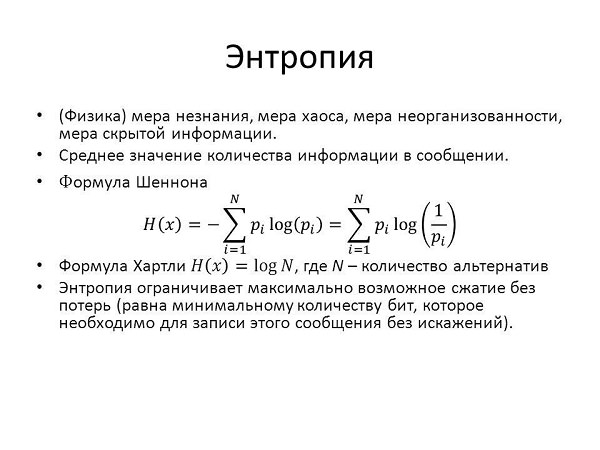

Поняття ентропії використовується в різних науках: фізиці, хімії, математики, біології, соціології. Саме слово походить від грецького і означає «перетворення, зміна». Що це таке, простими словами? Можна сказати, що це міра безладу, випадковості в будь-якій системі. Чим менше порядку, тим більше її значення. Якщо книги стоять на полиці, невпорядкованість у них менше, ніж якщо вони лежать купою.

Що означає термін

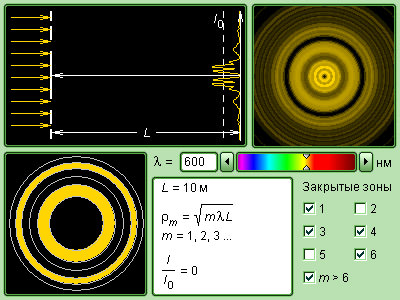

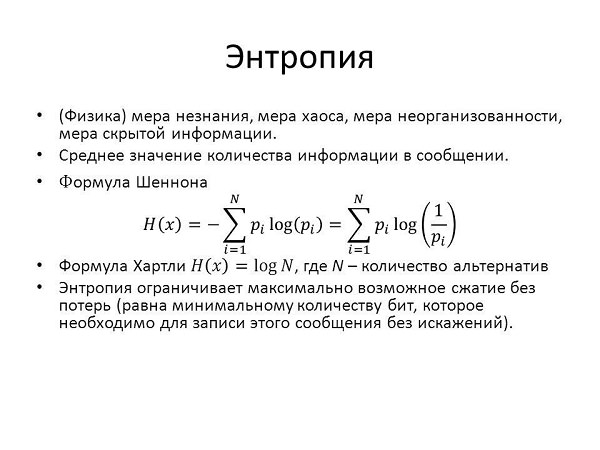

Визначення даного терміна залежить від сфери його застосування. У загальних словах можна сказати, що це міра безладу і незворотного розсіювання енергії. Чим більш впорядкована якась система, тим більш сконцентрована енергія. Наприклад, якщо ми помістимо гарячий предмет в холодну воду, поступово він охолоне, а вода нагріється. У другому випадку ентропія більше.

Важливо! Ентропія характеризує безлад. Чим вона більше, тим менше впорядкована система.

В якості системи може виступати що завгодно. У фізиці чи хімії це зазвичай газ, рідина, тверде тіло, набір певного числа частинок. В інформатиці це може бути текст, в соціології група людей.

Термін ентропія