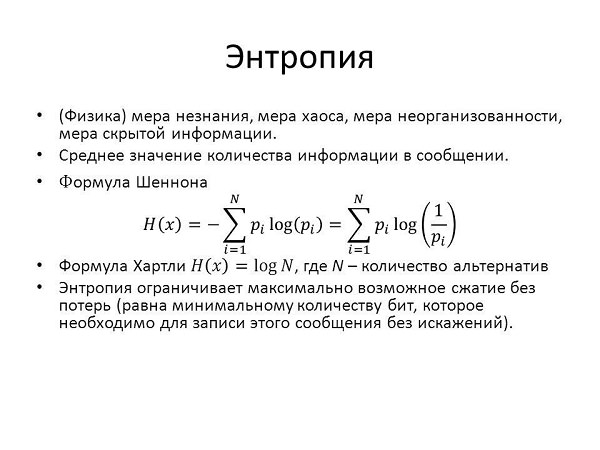

У теорії інформації

Інформаційна ентропія характеризує непередбачуваність якої-небудь системи. Наприклад, це може бути ймовірність появи якогось символу алфавіту в тексті. При цьому ця функція дорівнює кількості інформації, яке припадає на один символ. Клод Шеннон — вчений, який увів цей термін у теорії інформації, — навіть спочатку хотів називати цю величину інформацією.

Шеннон припустив, що, збільшуючи кількість інформації, ми зменшуємо невизначеність. Впорядковуючи систему, ми зменшуємо невизначеність.

Важливо! Чим більш передбачувано якась подія, тим воно менш інформативно, і тим менше безлад.

За допомогою цієї невизначеності можна передбачати події, наприклад, результат якогось експерименту. Для цього події ділять на окремі частини і вважають невизначеність для них.

Інформаційна ентропія пов’язана з кількістю доступних станів. Чим це число більше, тим вона більша. Наприклад, якщо ми будемо грати у шахи за правилами, для шахової дошки ця величина буде меншою, ніж якщо переставляти фігури хаотично. Невизначеність для монетки, яка може впасти тільки на одну або іншу сторону, не менше, ніж у гральної кістки з 6 гранями, а у кості з 20 гранями ця величина ще більше.

Існує також ентропія мови. Це поняття позначає кількість інформації на одиницю тексту на цій мові (один символ) і вимірюється в бітах на букву. Для різних мов вона різна.

У мові одні символи з’являються частіше, інші рідше, також є певні часто зустрічаються поєднання символів. Проводячи аналіз ймовірності появи того чи іншого символу, можна декодувати зашифрований текст. Інформаційна невпорядкованість також допомагає встановлювати необхідну пропускну здатність каналів для передачі зашифрованих повідомлень.

Для аналізу даних у різних сферах, від медицини до соціології, використовується інформаційно-ентропійний аналіз. Простими словами можна сказати, що, аналізуючи збільшення або зменшення безладу, можна встановити зв’язки між явищами.

Поняття «інформаційна ентропія» використовується також в математичній статистиці і статистичної фізики. Ці науки мають справу з імовірністю різних станів і використовують методи теорії ймовірності.